GPT-4o: Desvendando a Nova Geração de IA Omnimodal da OpenAI

Desvendando o GPT-4o: A Nova Era da Interação Humano-Máquina

No dinâmico universo da inteligência artificial, cada avanço representa um salto em direção a novas possibilidades. Recentemente, a OpenAI nos apresentou o GPT-4o – onde o 'o' significa omni –, um modelo que não é apenas mais uma iteração, mas sim uma redefinição do que esperamos de uma IA. Como um especialista que acompanha de perto a evolução dessa tecnologia, posso afirmar que o GPT-4o não é apenas mais rápido ou mais inteligente; ele é fundamentalmente diferente.

Este artigo tem como objetivo mergulhar profundamente nas capacidades do GPT-4o, explorando sua arquitetura omnimodal, suas inovações e o impacto que ele promete ter em diversas áreas, desde a forma como interagimos com a tecnologia até as novas fronteiras da criatividade e produtividade. Prepare-se para compreender por que este modelo é um marco e como ele está moldando o futuro da IA.

O Que é o GPT-4o e o Que Significa 'Omnimodal'?

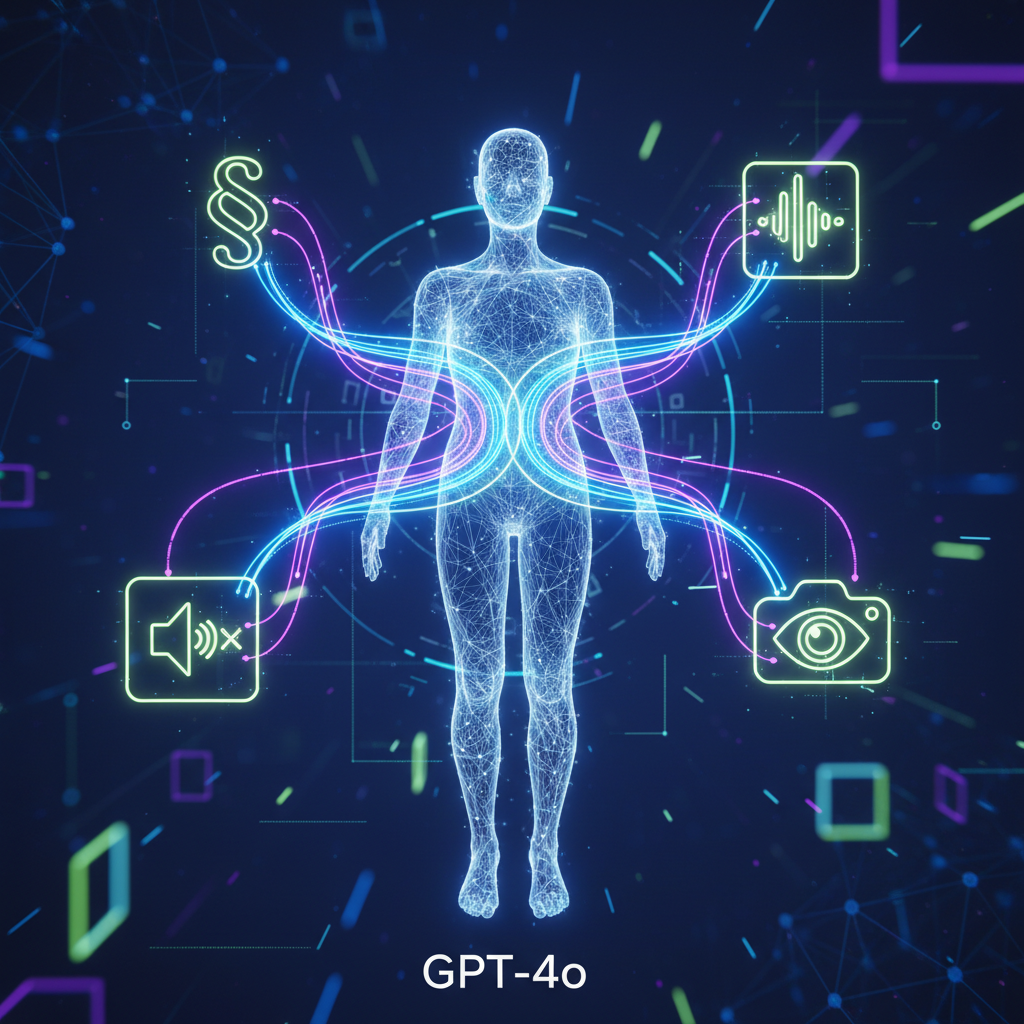

Para entender o GPT-4o, é crucial desmistificar o conceito de 'omnimodalidade'. Diferente de modelos anteriores que processavam diferentes tipos de dados (texto, áudio, imagem) através de componentes separados, o GPT-4o foi treinado desde o início como um modelo único e coeso para todas as modalidades.

Definição Clara: GPT-4o

O GPT-4o é o mais recente modelo carro-chefe da OpenAI, projetado para raciocinar através de áudio, visão e texto em tempo real. Isso significa que ele não apenas transcreve áudio para texto e depois o processa, ou analisa uma imagem separadamente; ele compreende a entrada em sua forma nativa – seja ela falada, visual ou escrita – e gera saídas nas mesmas modalidades de forma integrada e contextualizada.

A Revolução Omnimodal

A arquitetura omnimodal permite uma interação muito mais fluida e natural. Imagine conversar com uma IA que não apenas entende suas palavras, mas também o tom da sua voz, as nuances de uma imagem que você mostra e responde com uma voz que expressa emoção e entonação adequadas. Essa capacidade de processar e gerar informações em múltiplas modalidades nativamente é o que torna o GPT-4o um divisor de águas, eliminando os gargalos de latência e perda de contexto inerentes aos sistemas de encadeamento de modelos.

Principais Inovações e Recursos do GPT-4o

As inovações do GPT-4o vão muito além de meras melhorias incrementais. Elas representam um salto qualitativo na interação entre humanos e máquinas. Vamos explorar os aspectos mais marcantes:

Compreensão e Geração Multimodal Nativa

- Áudio em Tempo Real: Capacidade de processar áudio em milissegundos, com latência tão baixa quanto a de uma conversa humana. Ele pode identificar emoções, interrupções e até mesmo sons de fundo para contextualizar a interação.

- Visão Aprimorada: Analisa imagens e vídeos em tempo real, permitindo desde a resolução de problemas de matemática mostrados em uma folha até a descrição detalhada de cenas complexas, inferindo contextos e emoções visuais.

- Texto Acelerado e Preciso: Mantém e até supera a excelência do GPT-4 Turbo em tarefas de texto, mas com maior velocidade e eficiência.

Velocidade e Eficiência

O GPT-4o é significativamente mais rápido em todas as modalidades. Para interações de áudio, por exemplo, a latência média é de 320 milissegundos, um nível quase imperceptível para uma conversa natural. Além disso, a OpenAI anunciou que o modelo estará disponível via API com um custo até 50% menor que o GPT-4 Turbo, democratizando o acesso a essa tecnologia avançada.

Interpretação Emocional e Nuances

Uma das características mais impressionantes é a capacidade do GPT-4o de perceber e reagir a emoções na voz do usuário. Essa sensibilidade permite respostas mais empáticas, úteis e contextualmente ricas, tornando a interação com a IA mais humana e menos robótica.

GPT-4o vs. GPT-4 e Outros Modelos: Qual a Diferença?

Para entender a magnitude do GPT-4o, é fundamental compará-lo com seus antecessores e com os modelos líderes de mercado.

Um Salto Geracional em Multimodalidade

Enquanto o GPT-4 (e suas variações como o GPT-4 Turbo) era capaz de lidar com texto e, de forma limitada, com imagem e áudio (muitas vezes através de modelos auxiliares), o GPT-4o foi projetado para ser multimodal desde sua concepção. Isso elimina a necessidade de converter diferentes tipos de dados em um formato comum antes do processamento, resultando em:

- Latência Reduzida: Interações em tempo real, essenciais para aplicações de voz e vídeo.

- Melhor Preservação de Nuances: Informações contextuais (tom de voz, expressões visuais) são mantidas e utilizadas no raciocínio do modelo.

- Desempenho Otimizado: Supera o GPT-4 Turbo em benchmarks de áudio, visão e texto, especialmente em idiomas não ingleses.

Acessibilidade e Desempenho Superior

A combinação de desempenho superior com um custo-benefício mais atraente torna o GPT-4o uma ferramenta poderosa e mais acessível para desenvolvedores e empresas. Essa estratégia da OpenAI, aliás, está alinhada com a democratização da IA avançada, permitindo que um número maior de inovações seja construído sobre sua plataforma.

Aplicações Práticas e o Impacto no Cotidiano

As possibilidades que o GPT-4o abre são vastas e transformadoras. Vejamos alguns exemplos de como ele pode impactar nosso dia a dia:

Assistência Pessoal e Profissional

- Tutores de IA Interativos: Sistemas que podem 'ver' o que o aluno está trabalhando (ex: um problema de matemática manuscrito), 'ouvir' suas perguntas e 'explicar' conceitos complexos com uma voz natural e paciência.

- Assistentes de Voz Avançados: Muito além de comandos simples, capazes de participar de conversas complexas, gerenciar reuniões, fazer anotações e traduzir em tempo real, mantendo o contexto emocional.

- Atendimento ao Cliente Aprimorado: Bots que compreendem a frustração na voz do cliente e podem oferecer soluções mais empáticas e eficazes.

Criação de Conteúdo e Desenvolvimento

- Geração de Mídia: Criação de roteiros para vídeos, narrações com vozes personalizáveis, legendas automáticas e até mesmo assistência em processos de design visual, interpretando rascunhos e transformando-os em designs coerentes.

- Programação e Debugging: Desenvolvedores podem descrever problemas com a voz, mostrando o código em vídeo, e a IA pode ajudar a identificar erros e sugerir soluções em tempo real.

Educação e Acessibilidade

- Recursos para Pessoas com Deficiência: Tradução de Libras para voz, descrição de ambientes para deficientes visuais e transcrição em tempo real para deficientes auditivos, tudo com maior precisão e naturalidade.

- Aprendizado de Idiomas: Interação com a IA como um professor de idiomas, praticando pronúncia e conversação com feedback imediato e contextual.

Desafios e Considerações Éticas

É fundamental reconhecer que, junto com as vastas oportunidades, o GPT-4o traz consigo desafios éticos e práticos. A capacidade de gerar vozes e imagens realistas levanta preocupações sobre deepfakes e desinformação. A coleta e o uso de dados multimodais exigem rigorosos protocolos de privacidade e segurança. Além disso, a acessibilidade e o potencial impacto no mercado de trabalho são tópicos que precisam ser abordados com responsabilidade e foresight.

A OpenAI (mais informações em openai.com) tem se manifestado sobre essas preocupações, implementando salvaguardas e mecanismos de segurança. No entanto, o debate e a regulamentação continuam sendo essenciais à medida que a tecnologia evolui.

O Futuro da IA: Mais Perto e Mais Humano com o GPT-4o

O GPT-4o representa um passo gigante em direção a uma inteligência artificial que não apenas compreende a complexidade do mundo, mas também interage com ele de maneira mais natural e intuitiva. Sua capacidade omnimodal de processar e gerar informações em texto, áudio e vídeo em tempo real abre um leque de possibilidades que antes pareciam distantes.

Como especialista, vejo no GPT-4o um potencial imenso para transformar indústrias, aprimorar a educação, democratizar o acesso à informação e, fundamentalmente, mudar a forma como pensamos sobre a colaboração entre humanos e máquinas. Estamos testemunhando o surgimento de uma IA que não apenas responde a comandos, mas participa ativamente, compreende nuances e se adapta ao nosso modo de comunicação. O futuro da IA é mais próximo, mais pessoal e, com o GPT-4o, inegavelmente mais humano.

Leia Também